Dataflow Gen2

Dataflow je alat koji već jako dugo postoji u Power BI servisu, a koristi se za uvoz, transformaciju i učitavanje podataka u semantički model (ETL). Praktično, to je Power Query u cloud okruženju. Pojavom Microsoft Fabric-a uveden je Dataflow Gen2 koji je dosta napredniji u odnosu na prethodnu verziju i omogućava brži rad sa velikim količinama podataka, kao i njihovu paralelnu obradu.

Za razliku od prve verzije Dataflow-a koji koristi Power BI engine, a podatke čuva u vidu CSV datoteka u Azure Data Lake repozitorijumu, Dataflow Gen2 koristi Apache Spark u Fabric okruženju, a tabele čuva u Delta Parquet formatu (verzionirani Parquet), u OneLake-u. Podaci se još mogu uvesti i kao Lakehouse, Warehouse, SQL DB, Kusto itd.

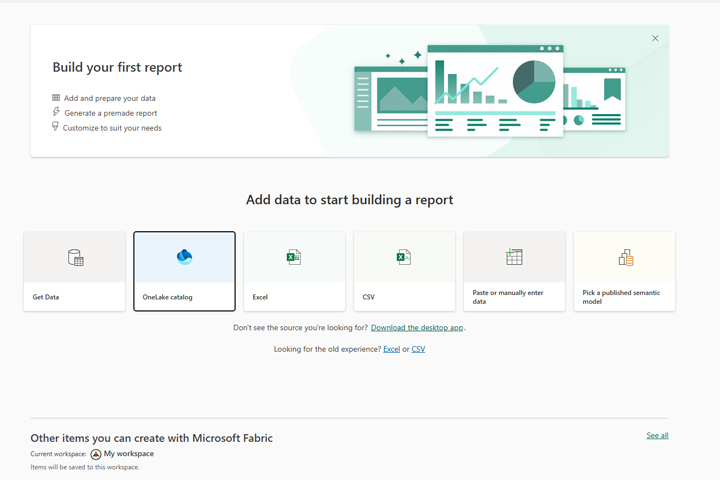

Dataflow Gen2 se koristi veoma jednostavno. Ako ste nekada radili sa Power Query alatom brzo ćete razumeti kako on radi. Najpre, ulogujte se u Power BI (Microsoft Fabric) servis. Zatim, kliknite na dugme Create. Otvoriće se prozor koji nudi više načina uvoza podataka. Izaberimo OneLake catalog.

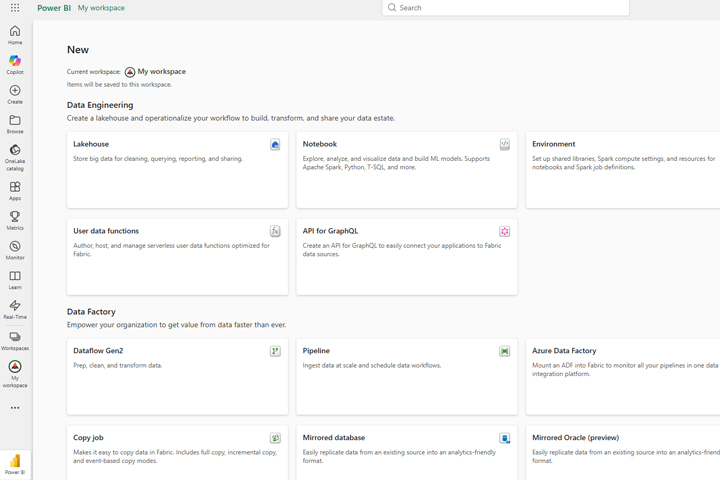

Otvoriće se prozor sa postojećim sadržajem kataloga. Kliknite na Add Content. Otvoriće se novi prozor koji prikazuje obilje sadržaja koje možete da kreirate. Umesto tradicionalnog modela ovom prilikom kreiraćemo Lakehouse. To je moderna arhitektura podataka koja kombinuje Data Lake (čuva nestrukturirane i polu-strukturirane podatke) i Data Warehouse (skrtukturirane tabele, pogodne za izveštavanje i analizu). Podaci se čuvaju u Delta Parquet tabelama, a moguće im je kasnije pristupiti i izvlačiti podatke neophodne za izveštavanje pomoću jezika PySpark (Python u Apache okruženju) ili SQL-a.

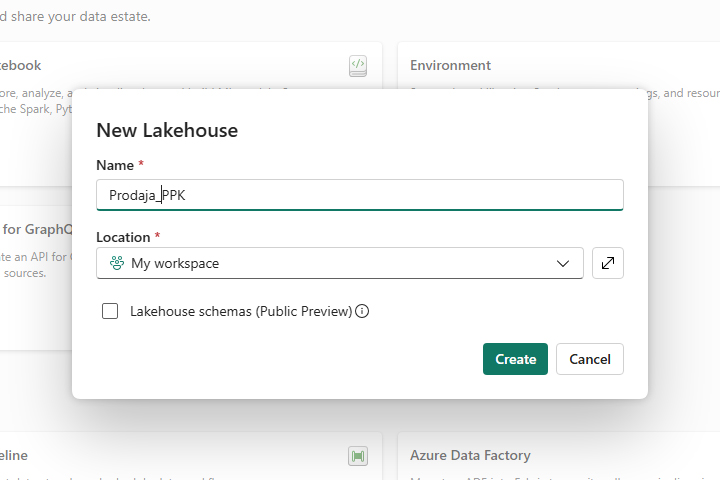

Otvoriće se prozor za kreiranje novog Lakehouse-a, gde ćemo mu dodeliti proizvoljno ime.

Nakon što je kreiran Lakehouse videćete njegovo ime, a u okviru njega dva foldera: Tables i Files. U folderu Files se čuvaju nestrukturirane i polu-strukturirane datoteke, a folder Tables sadrži tabele koje ćemo koristiti za izveštavanje i analizu. Paralelno sa kreiranjem Lakehouse-a automatski nastaje i SQL Analytics Endpoint koji služi da, ako to želite, izvlačite podatke pomoću SQL upita.

Otvorite meni Get Data, a zatim izaberite Dataflow Gen2 kako biste uvezli podatke. Kada se otvori prozor, dodelićemo mu neko pogodno ime, a zatim odabrati odakle želimo da uvezemo podatke: iz Excel datoteke, CSV datoteke, SQL servera, postojećeg Dataflow-a ili nekog drugog izvora. U ovom primeru, uvozimo podatke iz Excel datoteke!

Dalje, pojaviće se prozor za uvoz sličan onom u Power Query-ju gde je potrebno da označite jednu ili više tabela koje želite da uvezete.

Na kraju, rezultat uvoza se smešta u okruženje koje nalikuje Power Query Editor-u. Ovde je moguće dalje vršiti transformacije podataka dok ne budemo zadovoljni njihovim izgledom.

Transformisane tabele na kraju možemo da dodamo u željeni Lakehouse i da tamo nastavimo sa njihovim čuvanjem i upotrebom za kreiranje Power BI izveštaja.